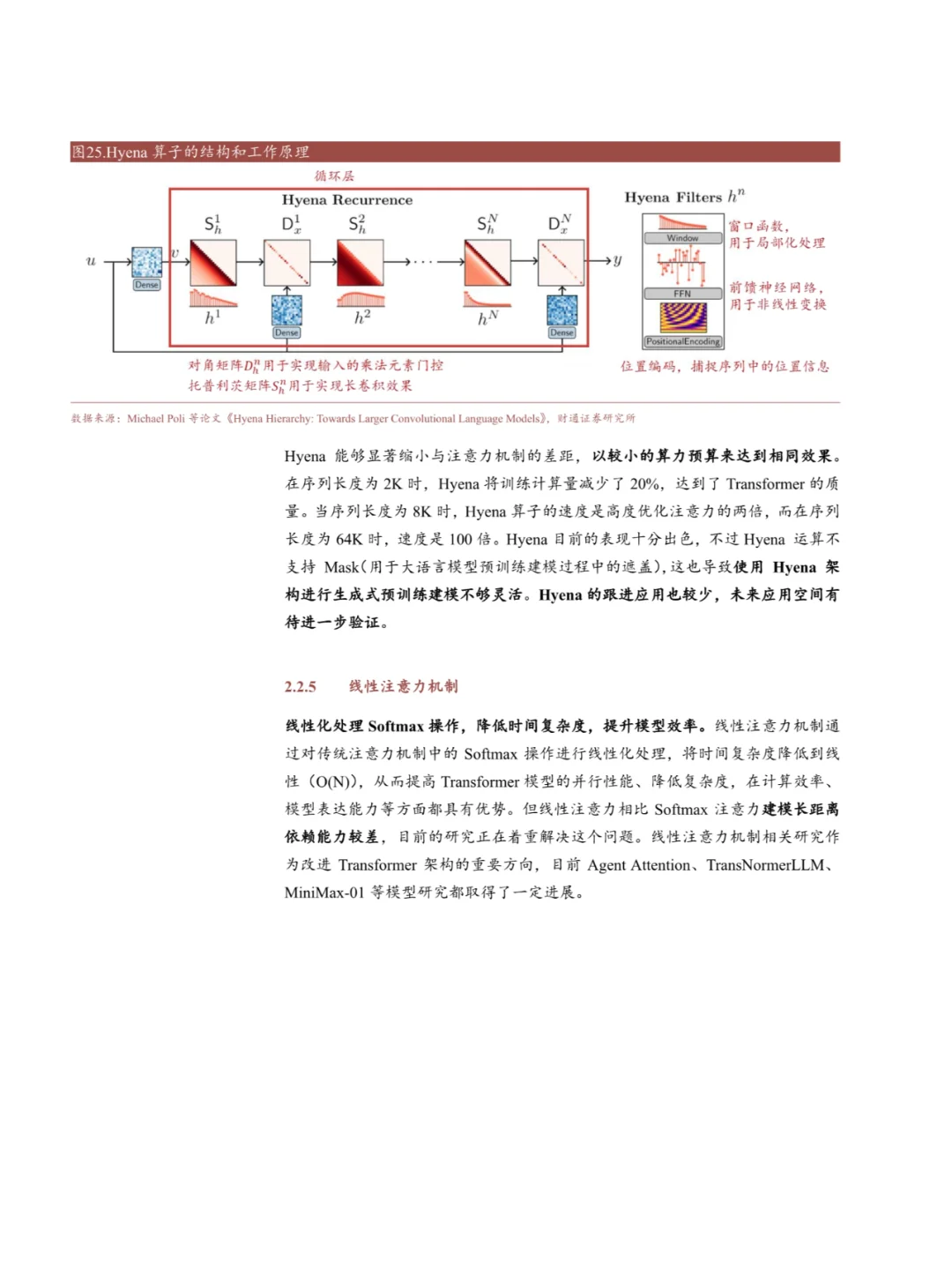

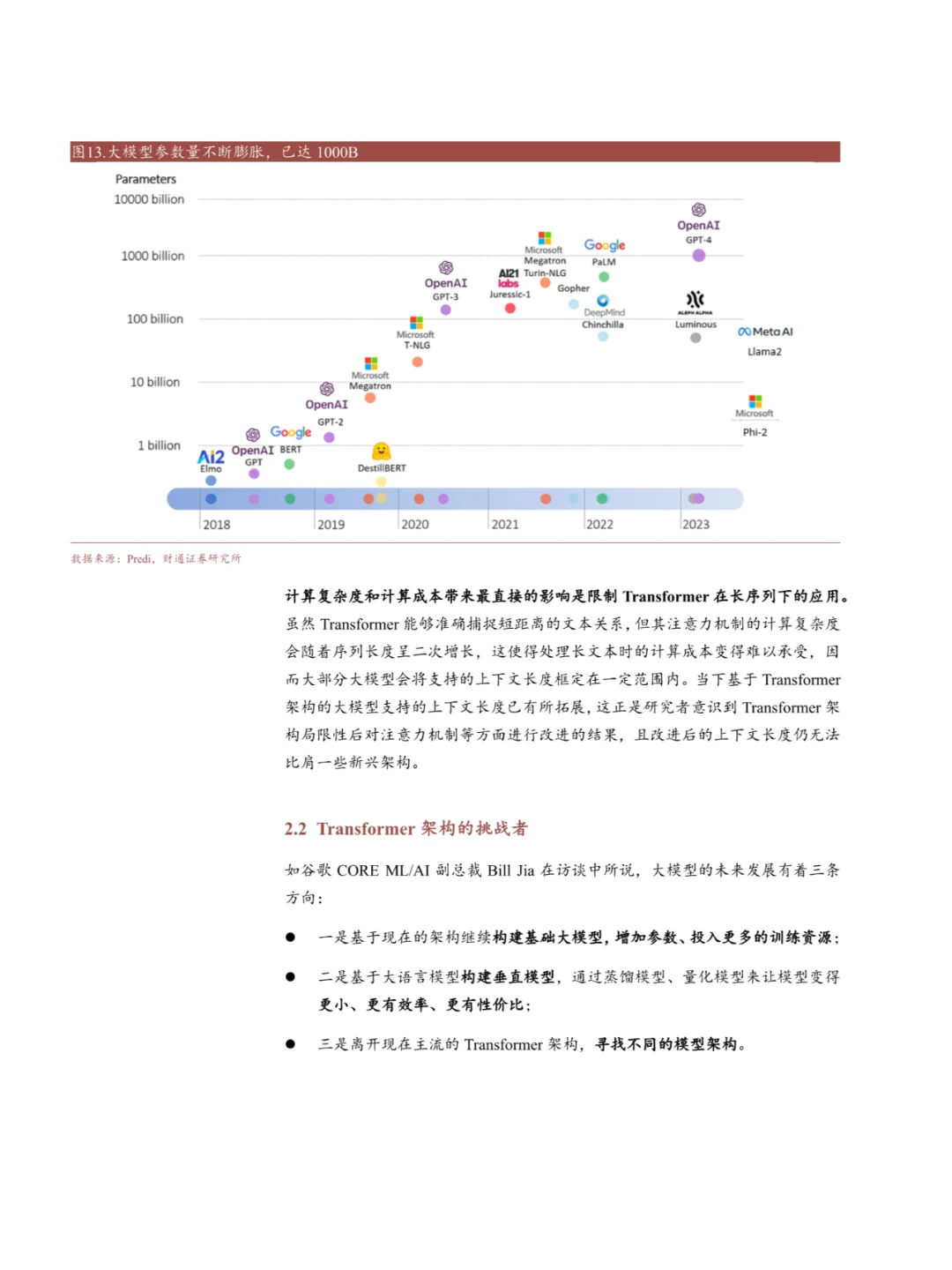

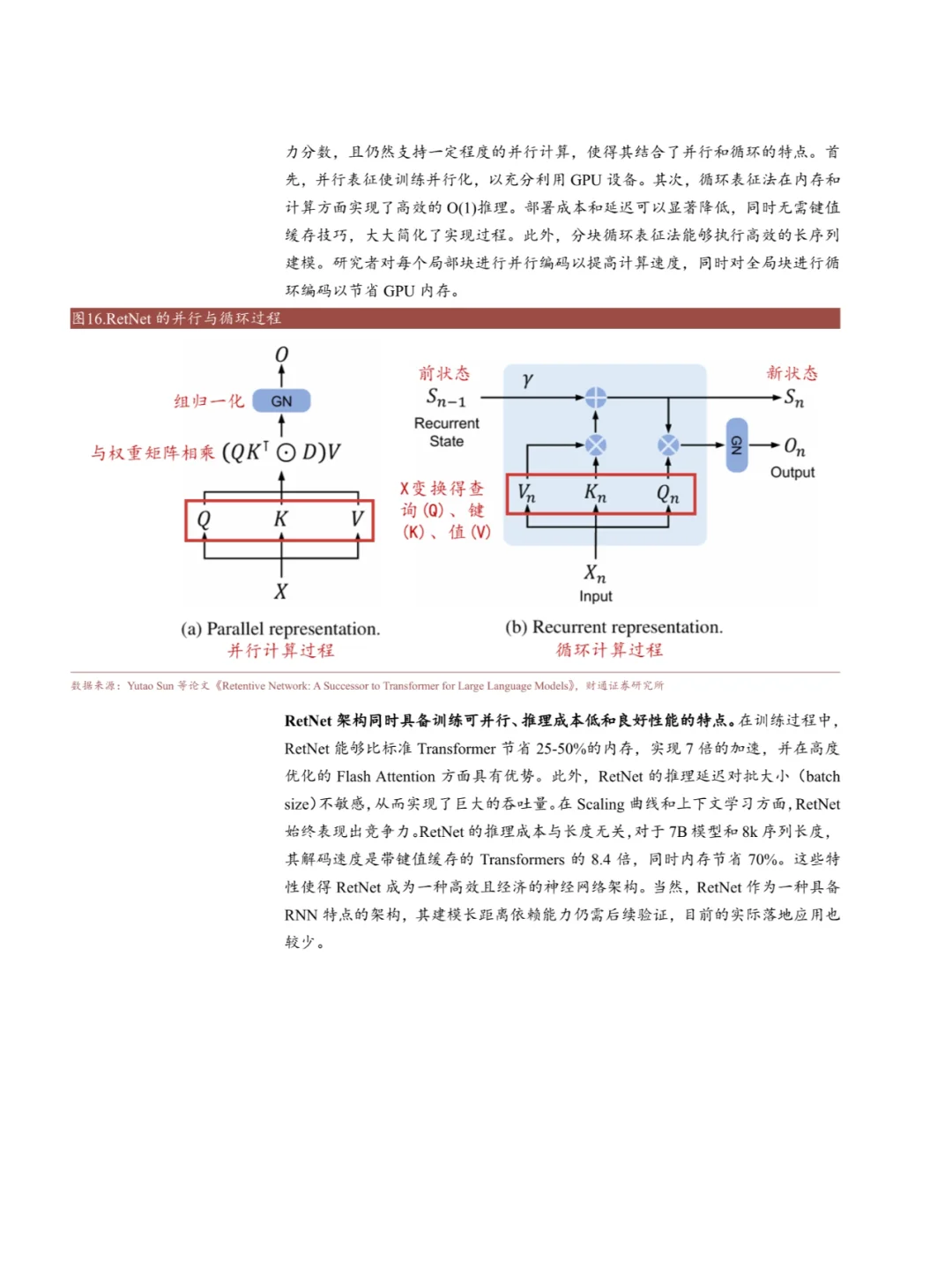

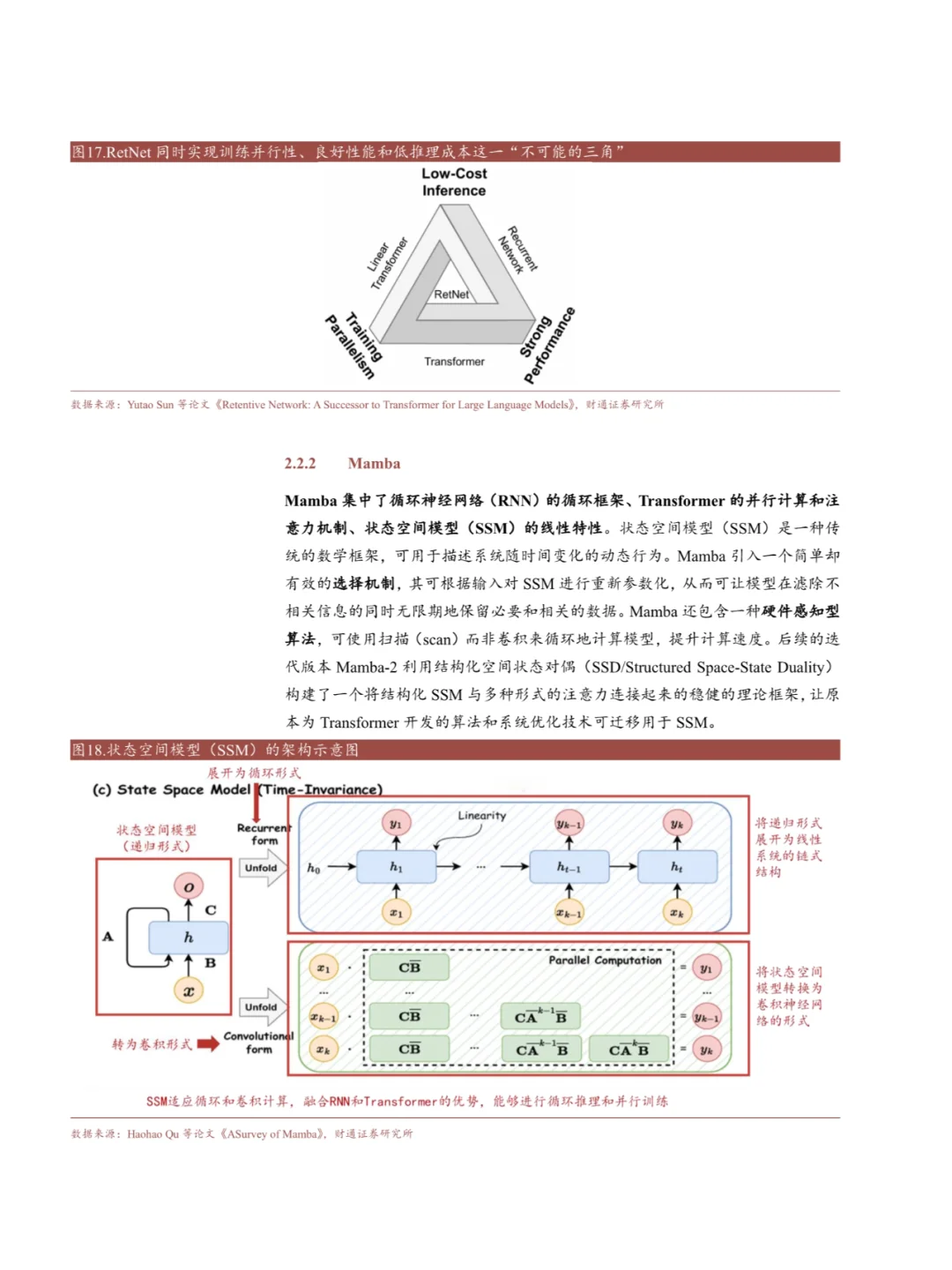

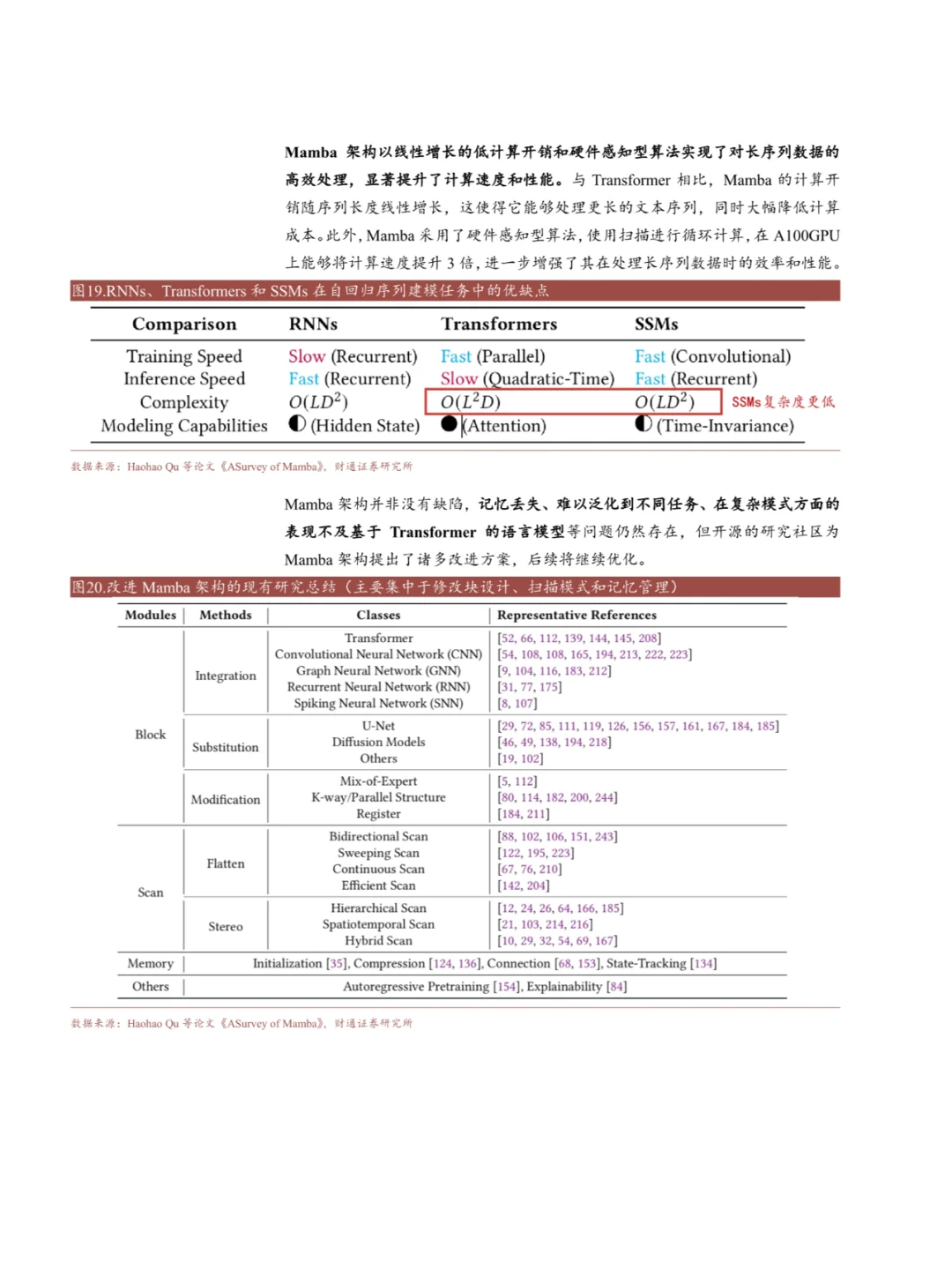

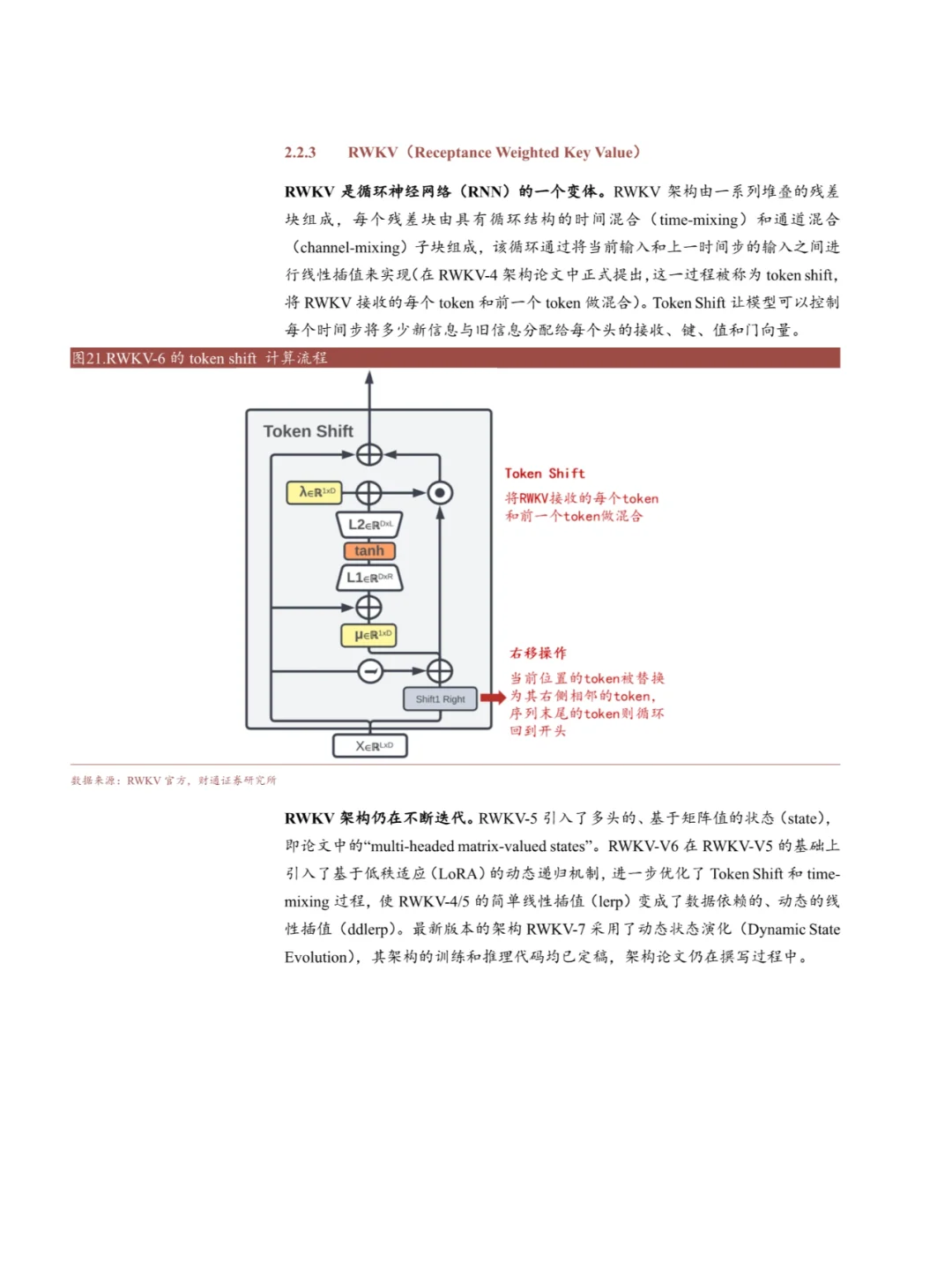

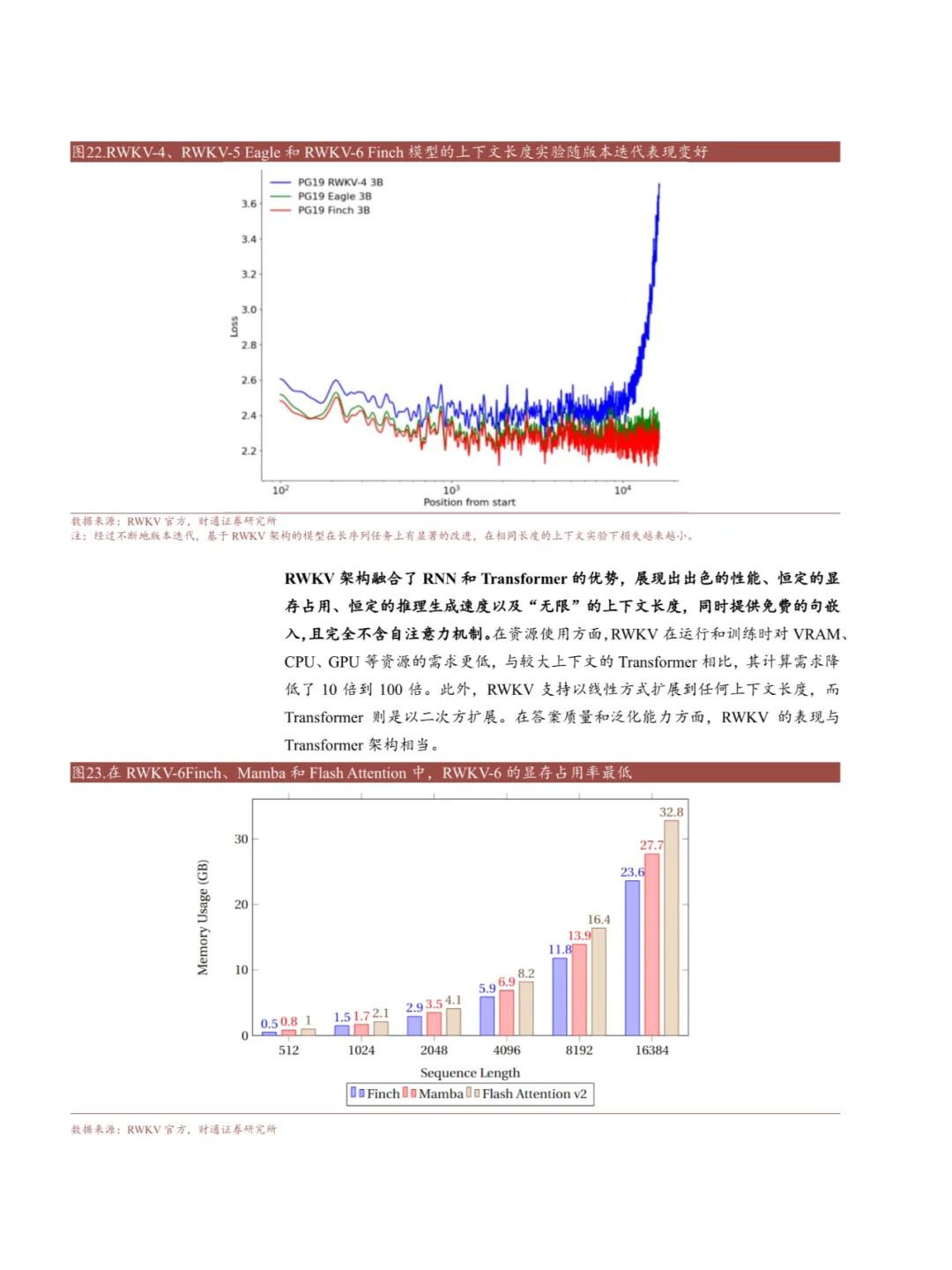

最近在研究2025年大模型Transformer架构的发展,发现了一些超有意思的亮点✨,忍不住分享给你们!。\n \n1. Transformer的过去与现在\nTransformer架构自2017年提出以来,凭借其并行处理和多模态能力,迅速成为自然语言处理(NLP)领域的主流。它的核心——自注意力机制,让模型能够同时处理序列中的多个元素,大大提升了训练效率和长距离依赖的捕捉能力。简单来说,Transformer就像是一个“超级大脑”,能够同时处理大量信息,快速做出决策🧠💨。\n \n2. Transformer的局限性\n虽然Transformer很强大,但它也有自己的短板。比如,计算复杂度高,随着序列长度的增加,计算成本呈二次方增长。这意味着处理长文本时,Transformer的计算资源和内存需求会急剧上升,导致训练和部署成本高昂💰。\n \n3. 未来展望\n未来的Transformer架构将朝着更低计算复杂度、更低成本和更高效率的方向发展。无论是通过优化现有架构,还是探索全新的模型架构,目标都是为了实现更高的性能、更强的泛化能力和更低的资源消耗。这不仅会推动AI在更多实际场景中的应用,还会让AI技术更加普惠化🌟。\n \n作为一名AI爱好者,看到这些技术的进步,真的让人兴奋不已!未来的AI将不再是少数人的专利,而是真正走进每个人的生活,帮助我们解决更多实际问题。让我们一起期待这个激动人心的未来吧!🚀\n \n完整报告可自取~\n \n来源:2025年深度行业分析研究报告\n共页数:24页\n \n#AI技术 #Transformer架构 #AI未来 #技术创新 #行业报告 #行业研究 #数据分析 #科技前沿

研报速递

研报速递

发表评论

发表评论: